Apprentissage par renforcement multi-agents dans le monde réel – Derniers développements et applications

31 mars 2025

31 mars 2025

Par Sriram Ganapathi Subramanian

La décision de l’Association for Computing Machinery de décerner le prix ACM A.M. Turing 2024 à Richard Sutton et Andrew Barto a reconnu le rôle important que joue aujourd’hui l’apprentissage par renforcement (RL) — un domaine qu’ils ont contribué à établir. Certains des grands modèles de langage (LLM) les plus populaires, comme ChatGPT et DeepSeek, utilisent largement les principes et algorithmes RL. Elle est également largement utilisée en robotique, véhicules autonomes et en soins de santé.

L’objectif de l’agent RL est de trouver des comportements quasi optimaux pour les tâches de prise de décision séquentielles en utilisant des signaux faibles (à valeur réelle) appelés récompenses. Cela contraste avec l’apprentissage supervisé, où les décisions sont prises d’un seul coup avec des signaux clairs sur la bonne réponse. Cette capacité d’apprentissage expérientiel basée sur l’essai-erreur du RL la rapproche des processus d’apprentissage observés chez les humains et tous les autres animaux. Les algorithmes RL classiques supposent généralement qu’il y a un seul agent d’apprentissage dans le système, sans qu’aucune autre entité dans l’environnement ne puisse exercer de l’agence. Cependant, les univers réels ont généralement plus d’un agent. Par exemple, en conduite autonome, les agents doivent constamment raisonner sur les autres conducteurs sur la route.

L’apprentissage par renforcement multi-agents (MARL), un sous-domaine émergent, assouplit cette hypothèse et considère l’apprentissage dans des environnements contenant plus d’un agent autonome. Bien qu’il y ait eu de nombreux succès avec les algorithmes MARL au cours de la dernière décennie, ils n’ont pas encore trouvé d’application large dans les problèmes réels à grande échelle pour deux raisons importantes. Premièrement, ces algorithmes ont une faible efficacité d’échantillonnage. Deuxièmement, ces algorithmes ne sont pas évolutifs vers des environnements avec de nombreux agents puisque, en général, ils sont exponentiels en nombre d’agents dans l’environnement, tant en temps qu’en espace.

Mes recherches visent globalement à répondre à ces limites et à accélérer le déploiement du MARL dans divers contextes réels, notamment la lutte contre les feux de forêt, la gestion des réseaux intelligents et la conduite autonome. Mon objectif à long terme est d’atteindre un déploiement aussi large et concret du MARL, qui se réalise à travers la poursuite de trois objectifs à court terme :

L’efficacité de l’échantillonnage est le problème d’apprendre efficacement à partir de chaque échantillon de données. Chaque échantillon de données dans RL/MARL constitue une expérience pour l’agent interagissant avec l’environnement. Les algorithmes MARL nécessitent habituellement des millions d’échantillons de données pour apprendre au niveau de la performance humaine, tandis que les humains peuvent apprendre de telles politiques à partir de seulement quelques échantillons. Par exemple, l’algorithme AlphaStar nécessite 200 ans de données de jeu pour apprendre de bonnes politiques. Un autre exemple est l’algorithme OpenAI Five , entraîné sur 180 ans de données de gameplay impliquant une infrastructure informatique composée de 256 GPU et 128 000 cœurs CPU. Dans de nombreux domaines réels, c’est un enjeu critique; Il y a une relative rareté de données pour que les agents puissent apprendre efficacement.

Des recherches antérieures recommandaient différentes approches pour améliorer l’efficacité de l’échantillon des méthodes MARL. Une recommandation est d’utiliser des récompenses supplémentaires ( appelées récompenses d’exploration) pour encourager l’apprentissage de certains comportements qui sont ensuite réduits avec le temps. D’autres recommandations incluent l’ajout d’une perte d’entropie pour la politique afin de décourager la convergence vers un optimum local et l’utilisation d’une motivation intrinsèque pour l’exploration. Bien que ces approches aient leurs mérites, des études récentes montrent que l’exploration récompense et la perte d’entropie peuvent modifier la politique optimale du problème initial (à moins d’être soigneusement élaborées pour chaque environnement), et la motivation intrinsèque peut ne pas être efficace dans plusieurs scénarios multi-agents. De plus, toutes ces approches entraînent les algorithmes MARL à partir de zéro dans chaque environnement, ce qui peut être inefficace.

Ma recherche adopte une approche différente. Une observation importante dans ce contexte est que de nombreux environnements réels déjà, en pratique, déploient des approches possiblement sous-optimales, conçues à la main (en utilisant des règles basées sur la physique) ou heuristiques pour générer des politiques. Une possibilité utile qui se présente est de tirer le meilleur parti de ces approches comme conseillers pour aider à améliorer la formation MARL. Nos travaux antérieurs portaient sur l’apprentissage à partir de sources externes de connaissances en MARL. Cependant, ces travaux reposent sur plusieurs hypothèses strictes qui empêchent leur application dans des environnements pratiques. Nos recherches précédentes fournissaient un cadre de principe pour intégrer des recommandations d’action provenant d’une classe générale de conseillers en ligne, possiblement sous-optimaux, dans des contextes multi-agents à somme générale non restrictive, dans le cas d’un seul directeur et de plusieurs conseillers. Nos recherches antérieures ont également fourni de nouveaux algorithmes RL pour un contrôle continu pouvant exploiter plusieurs conseillers. Par la suite, nous avons mené des études théoriques approfondies sur cette approche, offrant des garanties de performance et de stabilité. Quelques exemples de conseillers incluent les modèles de conduite en conduite autonome, les modèles de propagation basés sur la physique dans les feux de forêt, et les modèles mathématiques de marketing pour le marketing de produits. Les directeurs peuvent aussi être des humains ayant des connaissances préalables dans ces domaines. Alors que mon travail précédent se limitait à l’obtention de recommandations d’action des conseillers, mon travail actuel en cours étudie les effets d’une grande classe de méthodes de transfert multi-agents (par l’entremise de conseillers), telles que le transfert par les fonctions de valeur, la mise en forme de récompense et la politique.

Traditionnellement, les algorithmes MARL dépendaient exponentiellement du nombre d’agents dans les complexités temporelles et spatiales. Ainsi, ces algorithmes sont intractables dans des environnements avec de nombreux agents. Dans la littérature, ce problème est appelé la malédiction de la dimensionnalité.

Trois types différents de solutions ont été proposés pour l’échelle des algorithmes MARL : apprentissage indépendant (IL), partage de paramètres (PS) et méthodes de champ moyen . Chacun de ces points a ses avantages et ses inconvénients. Les méthodes IL considèrent tous les autres agents comme faisant partie de l’environnement et ne modélisent pas d’autres agents, ce qui les rend évolutifs. Bien que simples et efficaces dans certaines situations, ces méthodes ne sont pas théoriquement solides, il n’est donc pas tout à fait clair quels environnements ou situations multi-agents conviennent le mieux aux méthodes IL. Les méthodes PS utilisent un seul réseau pour l’entraînement, dont les paramètres sont partagés entre tous les agents. Ces méthodes ne sont applicables que dans des environnements coopératifs avec un ensemble d’agents homogènes. Les méthodes du champ moyen utilisent la théorie du champ moyen pour abstraire d’autres agents dans l’environnement par un agent moyen virtuel. Bien qu’efficaces, ces méthodes souffrent de plusieurs hypothèses strictes telles que l’exigence d’agents entièrement homogènes, une observabilité totale de l’environnement et des environnements d’apprentissage centralisés, qui empêchent leur application large dans les environnements pratiques.

Mes travaux précédents ont contribué à améliorer ces méthodes en abordant les limites existantes et en les rendant plus applicables. Pour les IL, nos recherches antérieures ont fourni une analyse expérimentale détaillée éclairant les forces et faiblesses des méthodes IL dans des environnements coopératifs, compétitifs et à motifs mixtes multi-agents. Nous avons démontré que les méthodes IL sont aussi efficaces que les méthodes d’apprentissage multi-agents dans plusieurs environnements coopératifs et compétitifs, mais souffrent dans les environnements à motifs mixtes. Concernant les méthodes PS, nos travaux antérieurs recommandaient de nouveaux protocoles de communication permettant aux agents de partager de l’information tout en utilisant des réseaux distincts et indépendants pour l’entraînement. Pour les méthodes de champ moyen, nos travaux antérieurs ont assoupli chacune des hypothèses restrictives. Premièrement, nous avons assoupli l’hypothèse d’exiger des agents entièrement homogènes en utilisant la classification par types. Ensuite, nous avons fourni de nouveaux algorithmes de champ moyen pouvant fonctionner efficacement dans des environnements partiellement observables. De plus, nous avons aussi fourni de nouveaux algorithmes de champ moyen capables d’apprendre de bonnes politiques en utilisant des protocoles d’apprentissage entièrement décentralisés . Cependant, les méthodes du champ moyen continuent d’avoir certaines limites, comme supposer que chaque agent a un impact similaire sur les autres agents, et montrer des comportements d’apprentissage instables, ce que j’aborde dans mes recherches actuelles.

Mes recherches portent sur l’efficacité des solutions RL et MARL dans un ensemble de domaines réels comme preuve de concept : lutte contre les feux de forêt, découverte de matériaux et conduite autonome.

Dans le domaine des feux de forêt, nos recherches antérieures portaient sur l’application du RL pour améliorer les modèles de simulation spatiale existants et préparer de meilleures stratégies de lutte contre les incendies pour deux grands événements d’incendies en Alberta : l’incendie de Fort McMurray et celui de Richardson. De plus, d’autres chercheurs ont publié un simulateur détaillé de feux de forêt Fire Commander qui simule l’effet des stratégies d’intervention et rapporte des métriques de brûlure. Bien que ce simulateur ait été utilisé pour tester les performances des algorithmes MARL dans des environnements de feux de forêt jouets fabriqués à la main, il n’y a eu aucune tentative d’étudier les performances des MARL dans des scénarios de contrôle d’incendie liés à un événement d’incendie réel. Mon travail actuel en cours porte sur une étude de cette envergure. De plus, nous avons publié un détaild Enquête sur l’application des algorithmes d’apprentissage automatique dans le domaine de la lutte contre les feux de forêt, ainsi qu’une liste détaillée de possibilités futures mettant en lumière un potentiel inexploité dans ce domaine. Cet article d’enquête a reçu une attention considérable, accumulant des centaines de citations en peu de temps.

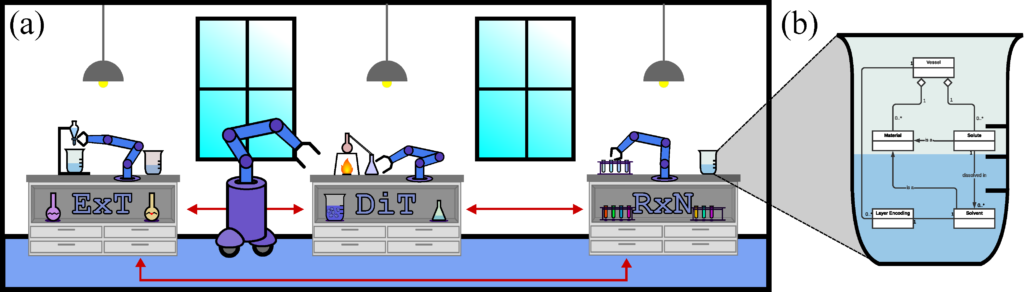

Dans la découverte de matériaux, des travaux antérieurs ont utilisé des techniques RL pour explorer un vaste espace chimique combinatoire, mais ont signalé des difficultés à obtenir suffisamment d’échantillons de données pour l’entraînement RL. Pour remédier à cette difficulté, nous avons récemment rendu open source un simulateur de gymnase de chimie qui simule l’effet de différentes réactions chimiques et qui est un outil efficace pour entraîner les algorithmes RL/MARL à gérer les réactifs chimiques. De plus, nous avons fourni une forme fondamentalement différente de RL, c’est-à-dire une formulation de récompense maximale, qui est plus pertinente pour la découverte de matériaux que la formulation standard qui utilise les récompenses cumulatives attendues.

Pour la conduite autonome, il y a des avantages rapportés à utiliser des techniques de RL à agent unique. Bien que la conduite soit un environnement multi-agents avec plusieurs véhicules différents sur la route en même temps, les travaux antérieurs étaient fortement limités à l’utilisation de techniques indépendantes. Nos travaux antérieurs ont permis de rendre plusieurs bancs d’essai MARL open source et de fournir de nouveaux algorithmes MARL pour la conduite autonome. Ces algorithmes surpassaient largement les techniques indépendantes. De plus, nous avons mené une vaste étude sur l’utilisation potentielle du RL pour apprendre les contraintes dans les environnements autoroutiers allemands et fourni de nouveaux algorithmes RL pour améliorer les décisions autonomes dans des conditions routières difficiles telles que les zones à fort trafic, les zones à faible visibilité et les itinéraires avec des conditions météorologiques difficiles. Mon travail en cours vise à améliorer davantage les capacités des MARL tant en conduite autonome qu’en découverte de matériaux, dans le but d’atteindre un large déploiement de MARL dans ces deux domaines.

Les algorithmes MARL ont le potentiel d’entraîner des agents autonomes et de les déployer dans des environnements partagés avec différents types d’autres agents. Ces agents peuvent atteindre leurs objectifs en collaborant et/ou en concurrençant d’autres agents (y compris ceux qu’ils n’ont peut-être jamais vus auparavant lors de leur formation). Après une formation approfondie sur des environnements complexes avec des adversaires, des scénarios et des objectifs divers, ces agents seront capables d’apprendre à naviguer de façon autonome dans des environnements dynamiquement changeants, à généraliser efficacement à de nouvelles situations et à planifier à l’avance en fonction de l’incertitude quant aux résultats de leurs actions ou stratégies. Notamment, les algorithmes MARL ont également démontré leur efficacité dans des environnements partiellement observables où ils peuvent exploiter efficacement des informations limitées capturées par les capteurs de l’agent.

Le déploiement de MARL dans le monde réel présente plusieurs avantages dans un large éventail de domaines d’application. Pour des applications critiques pour la sécurité, comme la lutte contre les feux de forêt, déployer de façon fiable plusieurs robots capables de combattre l’incendie de façon autonome pourrait réduire le nombre de pompiers humains au sol, sauvant des vies. Dans des domaines comme la santé, où il y a une pénurie de main-d’œuvre humaine, les agents autonomes peuvent aider à améliorer l’efficacité. Par exemple, il pourrait être possible d’observer un nombre accru de chirurgies assistées par des robots, de robots de soins pour les personnes âgées et d’assistants infirmiers robotisés. De nombreux autres domaines d’application comme la finance, la durabilité et la conduite autonome peuvent aussi bénéficier des algorithmes MARL, où les robots peuvent aider à automatiser les opérations, améliorer l’efficacité et réduire les coûts.

D’un point de vue technique, deux grandes limites sont l’empêchement d’un déploiement large des algorithmes MARL dans les problèmes réels. En raison de ces limitations, le MARL s’est traditionnellement concentré sur des problèmes simples impliquant deux (ou dizaines) d’agents avec un ensemble restreint d’applications. Mes recherches recommandent de nouvelles solutions à ces limites et explorent directement l’efficacité de ces solutions dans certaines applications réelles pour servir de preuve de concept. Elle comble l’écart entre les succès académiques en MARL et le déploiement dans le monde réel.