Blog de Vector Research : Grands modèles de langage, messages d'encouragement et PEFT

20 octobre 2023

20 octobre 2023

Par David Emerson

Avec l'émergence récente de grands modèles de langage (LLM) très performants et à usage général, tels que ChatGPT et LLaMA, l'intérêt de la recherche et du public pour les capacités et l'application de ces LM s'est rapidement accru. Étant donné qu'une quantité croissante de ressources se concentre sur l'avancement des frontières du traitement du langage naturel (NLP), et des LLM en particulier, il est devenu difficile de suivre ces changements. Dans ce billet, nous discutons de certaines tendances récentes dans les LLM et des techniques pour les appliquer à des tâches en aval, par le biais de l'ingénierie de l'invite. Nous discuterons également de nouvelles méthodes pour améliorer leurs performances au-delà du cadre traditionnel du réglage fin du modèle complet. Ces approches comprennent le réglage fin des instructions et le réglage fin efficace des paramètres. L'objectif est de mieux comprendre comment les LLM sont formés et comment ils peuvent être utilisés pour résoudre des problèmes réels.

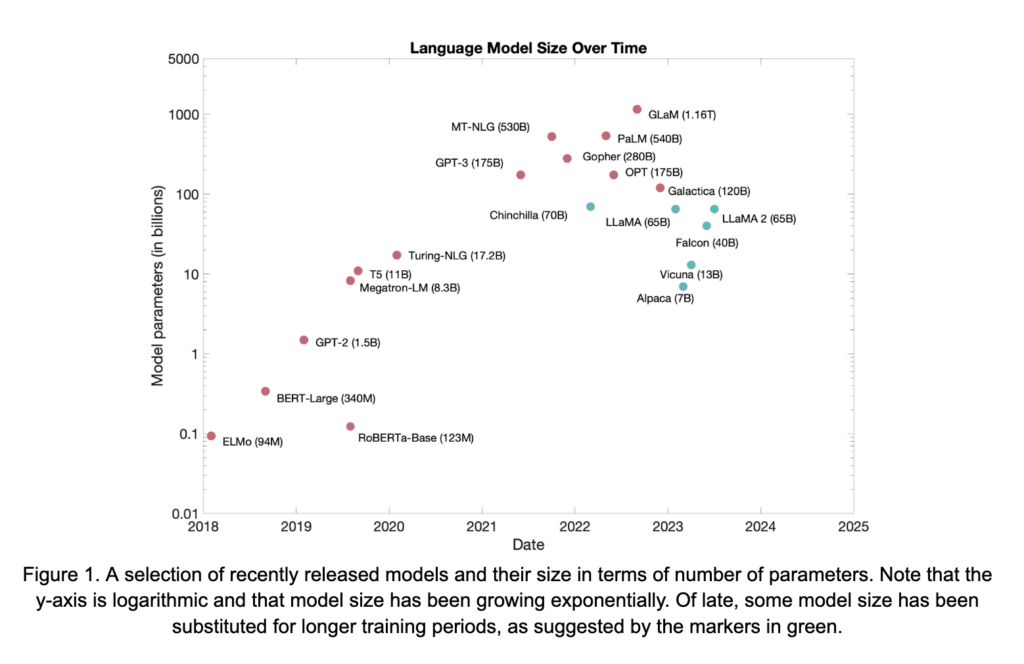

Au cours des dernières années, deux tendances importantes se sont développées en ce qui concerne les architectures LM et la formation, soutenues par de nombreuses percées et d'importants efforts d'ingénierie. Ces deux tendances sont présentes dans le diagramme d'échelle illustré à la figure 1. Alors que certains des modèles de la figure sont des modèles de style codeur seul, tels que BERT et RoBERTa, la majorité des LLM contemporains sont des modèles génératifs codeur-décodeur ou décodeur-transformateur seul. Par conséquent, ces architectures seront au centre de la discussion qui suit.

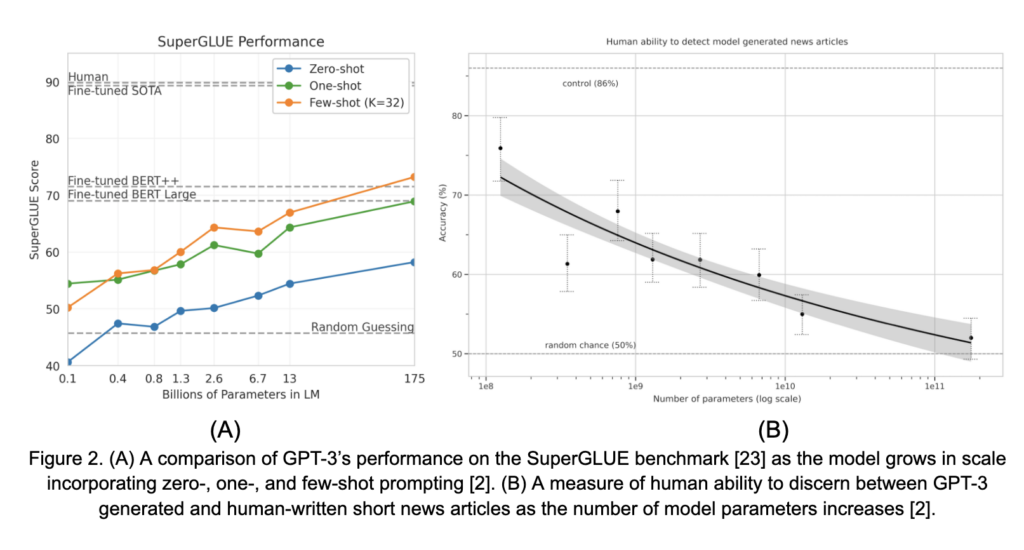

La première tendance évidente dans la figure 1 est que les LLM ont connu une croissance rapide au fil du temps. La mise à l'échelle de ces modèles a été facilitée de nombreuses façons, notamment par de meilleures techniques de pré-entraînement, des corpus de pré-entraînement plus importants et des progrès en matière de matériel et de méthodes d'entraînement distribuées, parmi beaucoup d'autres. Cependant, cette augmentation de la taille des modèles n'est pas simplement due à un souci de mise à l'échelle. Les capacités de ces modèles, en particulier leurs capacités de zéro et de quelques coups (discutées en détail ci-dessous), augmentent de manière significative avec l'échelle. Cet aspect a été mis en évidence de manière poignante dans [2]. Deux résultats de ce travail sont présentés dans la figure 2. Dans la figure 2A, les performances de GPT-3 sur le benchmark SuperGLUE, dans les paramètres zéro et quelques coups, augmentent de façon régulière avec la taille du modèle. De même, dans la figure 2B, la capacité humaine à distinguer les articles de presse courts générés par le GPT-3 de ceux rédigés par des humains diminue régulièrement vers le hasard à mesure que la taille du modèle augmente. Ces observations, ainsi que d'autres, ont suscité un grand intérêt pour l'échelle LM en tant que moyen d'obtenir des capacités générales pour les tâches de NLP.

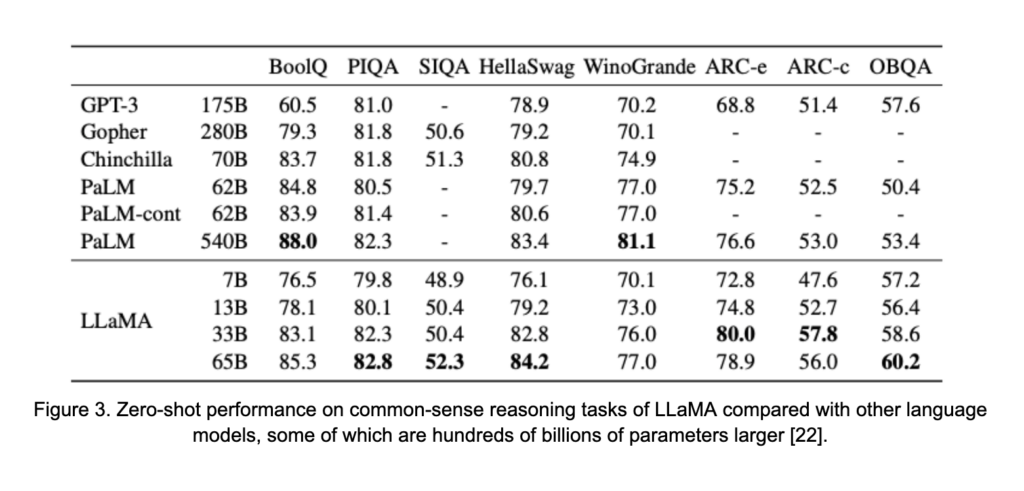

Le deuxième thème émergeant dans les LLM est plus subtilement présent dans la figure 1. Sur le côté droit, surligné en vert, se trouve un certain nombre de modèles performants récemment publiés. Bien que ces modèles restent assez grands, dans les dizaines de milliards de paramètres, ils ne suivent pas nécessairement la tendance de mise à l'échelle qui pourrait être déduite des modèles en rouge. Les modèles échangent une partie de leur taille contre des ensembles de données de pré-entraînement plus importants et des phases de pré-entraînement plus longues. Ce changement est motivé par l'étude dans [8], qui a suggéré que, malgré les ressources déjà significatives utilisées pour former de nombreux LLM, les modèles précédents sont sous-entraînés par rapport à leur taille. Ceci, par exemple, a conduit au cadre de formation de LLaMA [22], qui a vu 1,4 trillion de jetons pendant la formation. Ce total représente un grand bond en avant par rapport aux 300 milliards de jetons vus par OPT-175B [29], un modèle beaucoup plus grand, au cours de sa phase de pré-entraînement. Les résultats sont présentés dans la figure 3. Malgré sa taille plus petite, LLaMA surpasse les modèles avec jusqu'à 0.5 trillion de paramètres.

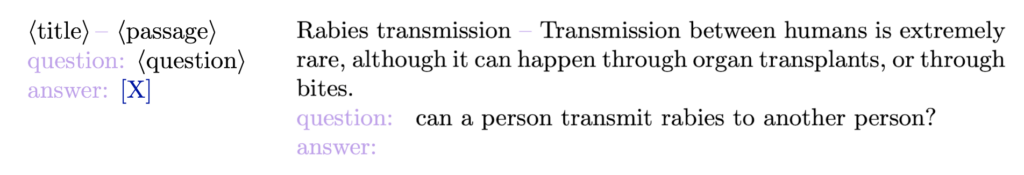

Formellement, l'incitation est le processus d'utilisation de phrases ou de modèles soigneusement élaborés pour construire un texte d'entrée qui conditionne un LM pré-entraîné à accomplir une tâche en aval. Nous avons déjà vu, dans les figures 2A et B, que les LLMs guidés sont capables d'effectuer des tâches avec un degré de précision surprenant sans avoir besoin d'un réglage fin. Avant de discuter plus avant, considérons l'exemple suivant de modèle d'invite et l'invite complétée associée pour la tâche BoolQ, tirée de [2].

À gauche, vous trouverez un exemple de modèle d'invite. Chaque élément entre parenthèses angulaires est rempli d'informations sur la tâche que nous espérons accomplir. Le texte lavande est une structure qui a été créée pour présenter clairement au modèle les informations requises. Enfin, l'objectif est de faire en sorte que le modèle génère du texte à la place du "X" de la marine avec la bonne réponse à la question. À droite se trouve un exemple de modèle rempli pour une question, avec le contexte, à partir de l'ensemble de données BoolQ.

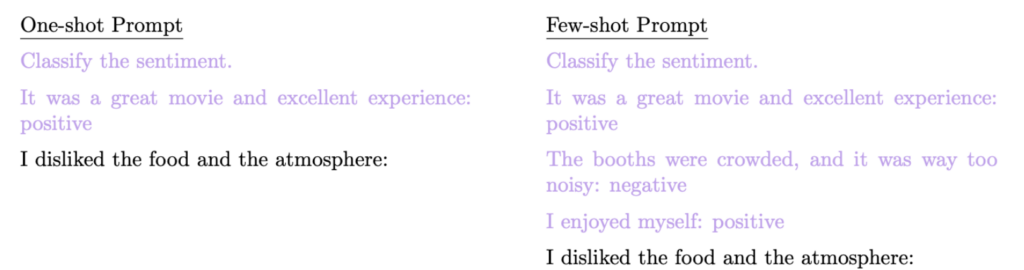

L'invite ci-dessus est connue sous le nom d'invite "zéro coup". Elle n'inclut aucun exemple "étiqueté", également appelé démonstration ou prise de vue, dans le cadre des données fournies au LM. Les invites à peu de tirages fournissent des exemples étiquetés dans le cadre du modèle d'invite, dans le but de fournir au LM des indications supplémentaires spécifiques à la tâche. Des exemples de messages-guides à un coup et à quelques coups pour une tâche de classification des sentiments sont présentés ci-dessous.

L'inclusion de démonstrations dans les messages-guides présente plusieurs avantages. Le premier d'entre eux est que la performance de la tâche en aval est souvent améliorée, comme le montre la figure 2. L'écart entre l'invite zéro et l'invite quelques fois se creuse souvent avec l'échelle du modèle. En outre, l'inclusion d'exemples étiquetés encourage fortement le modèle à répondre d'une manière qui facilite la mise en correspondance du texte généré avec une étiquette, ce qui est un défi courant avec les messages-guides. Prenons l'exemple de la tâche d'analyse des sentiments ci-dessus. L'espace d'étiquetage pour la tâche est "positif" et "négatif". Cependant, le modèle, laissé à lui-même, pourrait répondre par "agréable" ou "décevant", ce qui complique le processus de détermination programmatique de l'étiquette prédite. L'inclusion d'exemples aide le modèle à répondre de la manière que nous attendons.

La manière dont les LM intègrent les démonstrations dans le processus prédictif est nuancée. Plusieurs études ont montré que la qualité, la distribution et même l'ordre des démonstrations fournies ont un impact important et parfois imprévisible sur la capacité d'un modèle à effectuer une tâche en aval [17,18,26]. À cette fin, certaines recherches ont envisagé des stratégies de sélection des démonstrations optimales à inclure dans une invite afin de maximiser les performances des tâches en aval par rapport à une simple sélection et à un ordre aléatoires [1,15].

Bien que l'incitation à quelques coups soit très efficace, il y a plusieurs inconvénients à garder à l'esprit. Tout d'abord, les démonstrations occupent un espace précieux dans la capacité d'entrée des LMs (également connue sous le nom de contexte). En général, les transformateurs sont capables de consommer un nombre fixe de jetons pour conditionner le processus de génération. Par exemple, LLaMA a une longueur de contexte fixe de 2048 tokens. Bien que cela semble être beaucoup de tokens, l'injection de plusieurs démonstrations s'additionne rapidement, en particulier pour une tâche telle que le résumé de documents où chaque démonstration peut incorporer un grand morceau de texte. Cela limite le nombre d'exemples pouvant être inclus dans les messages-guides. Plus important encore, les contextes de grande taille entraînent des coûts de calcul élevés et ralentissent l'inférence. Cela s'explique par le fait que, par exemple, l'attention dans les transformateurs est un processus de calcul. opération, dans le cadre de laquelle

est le nombre de tokens dans le contexte.

Un autre inconvénient est que les données étiquetées peuvent être privées. Dans [6], des attaques par inférence d'appartenance ont été conçues avec succès pour révéler les données étiquetées utilisées dans les messages-guides de quelques secondes. Bien que ce travail ait également proposé une approche pour protéger ces données, l'inclusion de données sensibles dans les invites reste un risque. Enfin, plusieurs travaux ont montré que, pour certaines tâches, l'utilisation de quelques invites n'est pas suffisante pour obtenir de bonnes performances de la part d'un LM [12,25]. Cela a motivé des recherches importantes sur les messages-guides de type "chaîne de pensée", qui seront abordés en détail dans un prochain article de blog.

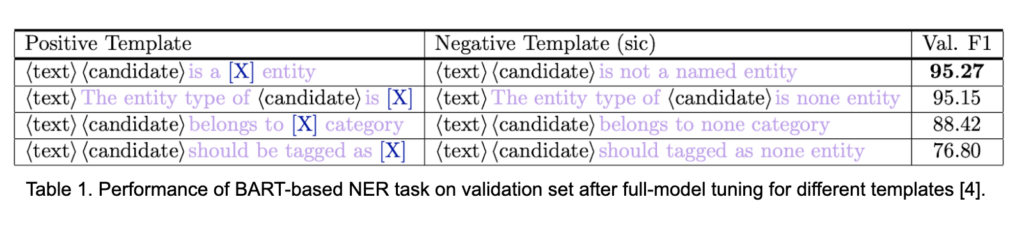

Pour la plupart des tâches en aval, l'objectif d'une invite est de maximiser la capacité des LM à effectuer cette tâche avec peu ou pas de besoin de données étiquetées. Cependant, même les LM les plus performants sont sensibles à la structure de l'invite fournie. La manière dont vous demandez au modèle d'exécuter la tâche cible est importante, et c'est même parfois le facteur déterminant qui garantit l'achèvement de la tâche. Prenons les exemples détaillés dans le tableau 1 de [4]. Chaque ligne du tableau correspond à un modèle potentiel pour une tâche de reconnaissance d'entités nommées. Il existe une grande différence de performance entre un modèle utilisant l'invite la plus performante (ligne du haut) et la moins performante (ligne du bas). Cette différence est encore plus marquée si l'on considère que le modèle est en fait affiné pour cette tâche en utilisant ces structures d'invite. La sensibilité des LM à la structure de l'invite est bien documentée et implique qu'une conception réfléchie de l'invite peut avoir un impact important sur les performances du modèle.

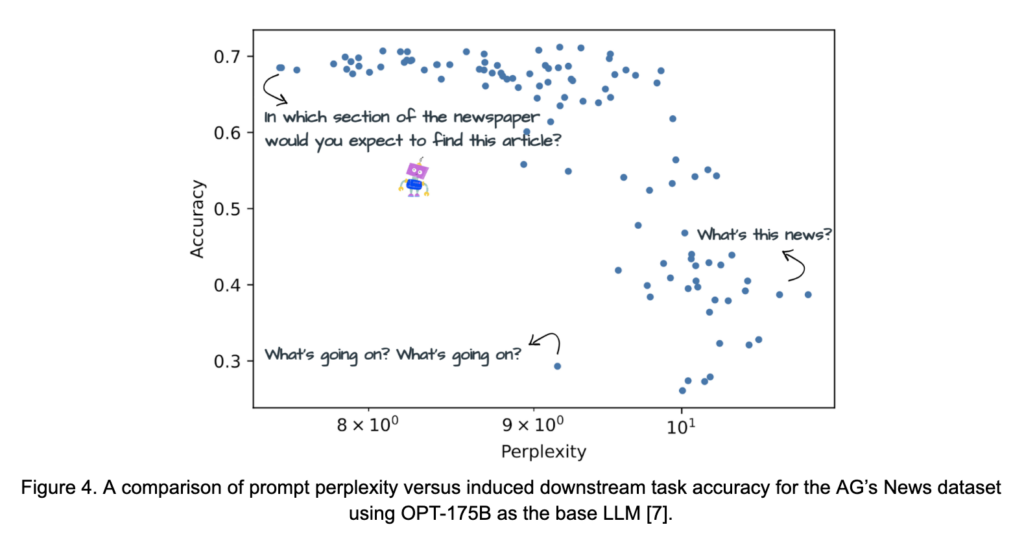

Dans cette optique, un certain nombre d'études se sont penchées sur la question suivante : "Qu'est-ce qui fait qu'une invite est bonne ? "Qu'est-ce qui fait qu'une invite est une bonne invite ?" La question est complexe, car certains types d'invites conviennent mieux à certains types de modèles. Par exemple, les auteurs de l'OPT ont observé que le modèle ne répondait pas bien aux "instructions déclaratives ou aux interrogations à brûle-pourpoint [29]". Il n'en va pas nécessairement de même pour les modèles affinés en fonction des instructions, dont il est question ci-dessous, tels que Vicuna [3]. Néanmoins, plusieurs études ont mis en évidence certains principes qu'il est utile de garder à l'esprit lors de la construction de messages-guides. Dans [7], la relation entre l'efficacité d'une invite et sa perplexité - une mesure proximale de la fluidité et de la simplicité d'une invite du point de vue des LM - est étudiée. Cette relation est illustrée à la figure 4 pour les messages-guides destinés à classer des articles de presse dans des catégories. Les travaux suggèrent empiriquement que les invites qui sont simples, fluides et spécifiques à la tâche sont les plus performantes. Une autre série d'études [19] a compilé un ensemble de suggestions de conception d'invites basées sur l'expérimentation de la famille GPT de LM. Il s'agit notamment de

Bien que ces recommandations permettent d'orienter l'exploration et la conception de messages-guides optimaux, il est important de reconnaître qu'il est souvent nécessaire d'expérimenter la construction de messages-guides pour obtenir des performances optimales de la part d'un LM dans une tâche particulière.

Étant donné que la conception manuelle des messages-guides peut s'avérer difficile, mais aussi essentielle à la réussite d'une tâche en aval, un grand nombre de travaux de recherche ont visé à améliorer le processus de recherche par le biais de diverses procédures d'optimisation. La plus simple de ces approches consiste à générer un ensemble diversifié d'invites sur lesquelles les performances peuvent être évaluées. Parmi les exemples, on peut citer l'extraction d'invites [10], où la formulation et le texte courant sont extraits de vastes corpus de textes pour construire diverses invites, et la paraphrase d'invites [7,10,28], dans laquelle une grande variété d'invites est créée à partir d'invites "de base" par le biais d'une traduction aller-retour, d'un remplacement de thésaurus ou de modèles de paraphrase. Chacune de ces méthodes vise à développer les messages-guides conçus par l'homme afin d'évaluer un plus grand nombre de candidats. Une variante sophistiquée de ces approches est GrIPS [20], qui combine ces approches, ainsi que plusieurs schémas d'édition de texte, pour rechercher de manière itérative des conceptions d'invites optimales.

Une approche d'optimisation intéressante, connue sous le nom d'AutoPrompt, est proposée dans [21]. Cette approche recherche un ensemble d'éléments "déclencheurs" de la forme

Laisser représentent le vocabulaire du LM considéré. Pour une étiquette

et la partie du vocabulaire qui lui est associée, les messages sont notés comme suit

A chaque itération, un jeton, avec l'encastrement

est sélectionné pour être modifié. Nous recherchons

avec l'encastrement

qui ont le plus de chances d'augmenter la probabilité d'étiquetage, comme l'indique l'équation (3.1),

où est le nombre de jetons de remplacement candidats à prendre en considération. La modification de la valeur de

-th prompt token with

pour former

nous sélectionnons le

qui maximise les probabilités d'étiquetage sur un lot d'apprentissage tiré de manière indépendante

comme

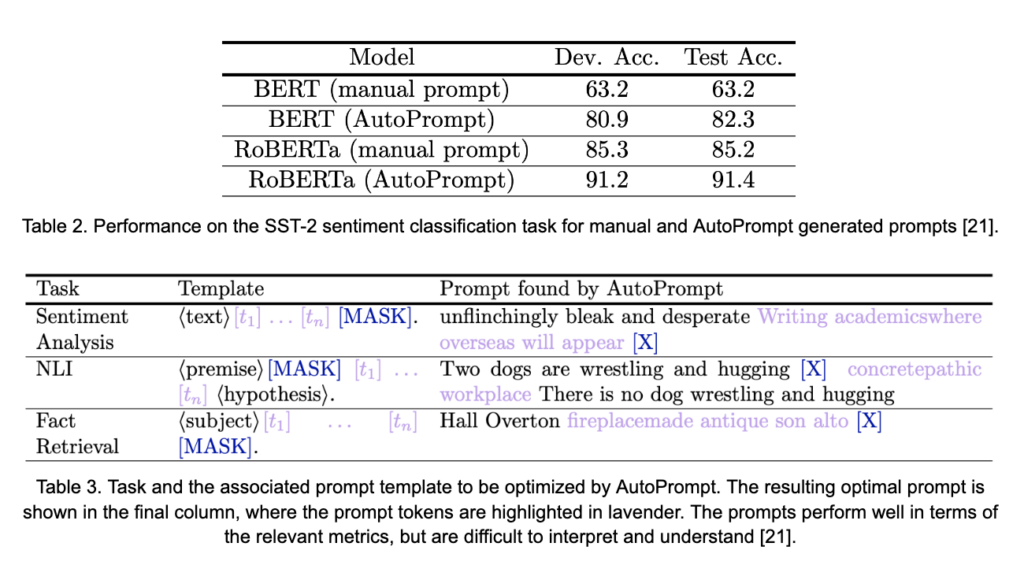

Cette approche peut s'avérer très productive pour accroître l'efficacité des invites, comme le montre le tableau 2. La précision induite par les invites manuelles des modèles BERT et RoBERTa pour le sentiment SST-2 est améliorée de 19,1 % et 6,2 %, respectivement. Bien que ces améliorations soient considérables, cette approche présente certains inconvénients. Le premier est que la méthode nécessite le calcul d'un gradient par rapport à l'intégration du vocabulaire du modèle. Bien qu'aucun paramètre ne soit mis à jour dans ce processus, le calcul du gradient pour les LLM, même pour un petit sous-ensemble de paramètres, peut être très gourmand en ressources. En outre, les messages-guides résultant de cette approche d'optimisation basée sur les jetons sont souvent difficiles à lire et tendent à ressembler peu aux messages-guides qu'un humain pourrait construire. Ce point est mis en évidence dans le tableau 3. Certaines recherches en cours visent à résoudre ce problème qui, en général, affecte de nombreuses autres approches d'optimisation des invites discrètes telles que RLPrompt [5]. Toutefois, il s'agit encore d'un domaine de recherche active.

L'incitation présente un certain nombre d'avantages importants. Grâce aux messages-guides, les LLM démontrent une capacité frappante à effectuer des tâches pour lesquelles ils n'ont jamais été formés. De plus, la mise en lot de plusieurs tâches est facilement réalisable par le biais de l'incitation. C'est-à-dire que le même LLM peut être utilisé pour de nombreuses tâches différentes, même dans le même lot, en modifiant simplement l'invite. En outre, l'interaction et l'inférence du modèle sont réalisées uniquement par le biais du langage naturel, ce qui réduit les obstacles à l'utilisation des modèles. D'un autre côté, nous savons que la performance des tâches reste très sensible à la conception des messages-guides. De plus, la recherche d'invites optimales est difficile et souvent fastidieuse. Enfin, et c'est peut-être le point le plus important, pour de nombreuses tâches, un écart important subsiste entre les performances des modèles d'apprentissage à l'invite et les modèles spécifiques à une tâche, entraînés pour effectuer une seule tâche avec une grande fidélité. Ces inconvénients ont motivé des approches supplémentaires pour améliorer les capacités des LLM à accomplir des tâches spécifiques en aval, tout en essayant de préserver autant que possible les avantages de l'approche des messages-guides.

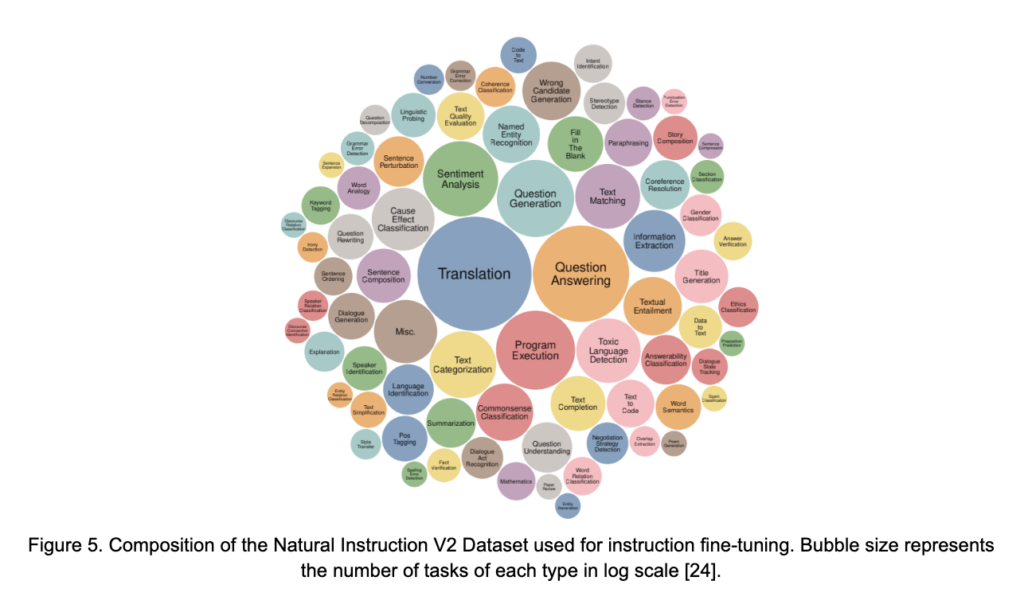

L'observation selon laquelle l'OPT ne répond pas bien aux "instructions déclaratives ou aux interrogations à brûle-pourpoint", qui a été brièvement abordée ci-dessus, est à la fois une affirmation vraie sur le LLM et un fait qui rend plus difficile l'incitation du modèle à effectuer des tâches en aval. Les instructions directes et les questions directes sont souvent une façon naturelle pour quelqu'un de commencer à interagir avec un LM génératif. Le réglage fin des instructions (IFT) vise à améliorer la performance des instructions tout en rendant le processus plus intuitif. L'idée de base est de fournir à un LM cible des exemples supplémentaires, en plus de ceux vus pendant le pré-entraînement, avec une structure spéciale. Pour l'IFT, cette structure spéciale se présente sous la forme d'invites d'instruction associées à une réponse générée souhaitée dans une grande variété de tâches NLP. L'échelle et la qualité de ces ensembles de données sont importantes pour la réussite du processus IFT. L'un de ces ensembles de données est le Natural Instruction V2 Dataset introduit par [24]. Cet ensemble de données comprend plus de 1600 tâches différentes, issues de 76 catégories de tâches différentes, chacune associée à un message d'instruction. La figure 5 illustre les différentes tâches et leur représentation relative dans l'ensemble de données.

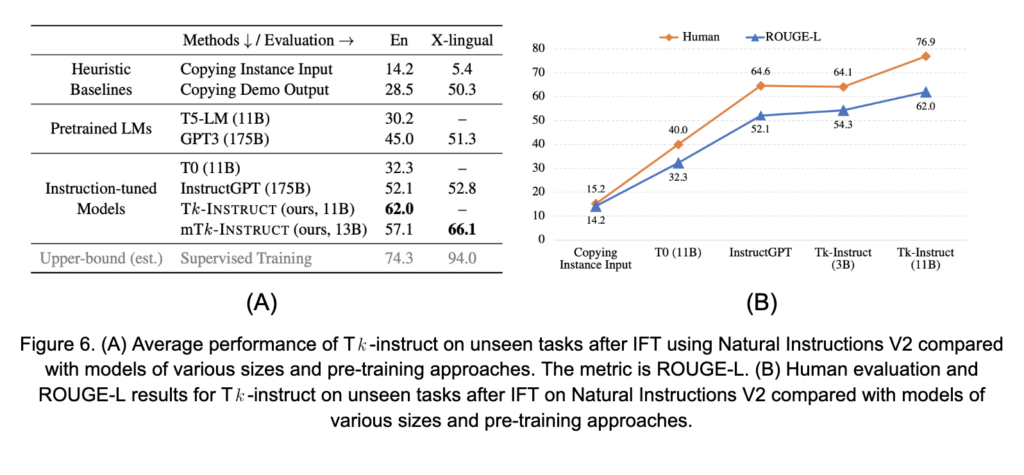

Pour l'IFT, le LM cible est encore affiné (également connu sous le nom de méta-tuning) sur le texte tiré de l'ensemble de données de l'IFT. L'inconvénient de cette approche est qu'elle nécessite des ressources informatiques équivalentes au réglage fin du modèle complet, bien que pour une période beaucoup plus courte que les cycles de pré-entraînement de la plupart des LLM. D'un autre côté, il a été démontré que cette approche améliore la capacité d'un LM à intégrer des messages-guides et à effectuer des tâches en aval conformément aux instructions. Voir, par exemple, les résultats de [24] montrés dans les figures 6A et B. L'IFT préserve de nombreux avantages de l'incitation tout en visant à améliorer l'efficacité de l'incitation pour les modèles cibles. Les principaux inconvénients sont que l'IFT reste essentiellement un réglage fin, qu'il nécessite des critères d'arrêt prudents pour éviter de perdre les capacités générales du modèle (oubli catastrophique) et qu'il ne comble pas nécessairement l'écart entre l'état de l'art et le réglage fin spécifique à une tâche.

Le réglage fin du modèle complet des LLM est souvent rendu complètement infaisable en raison des ressources informatiques massives requises pour effectuer la formation, même pour de courtes périodes de temps [27]. De plus, même avec les ressources pour produire une version spécifique d'un LLM, il est probable qu'un modèle séparé doit être affiné pour chaque tâche distincte, ce qui nécessite la duplication de l'infrastructure de stockage, de calcul et d'hébergement pour utiliser réellement ces modèles. C'est pourquoi des approches alternatives ont été recherchées pour combler l'écart susmentionné dans la performance du LLM.

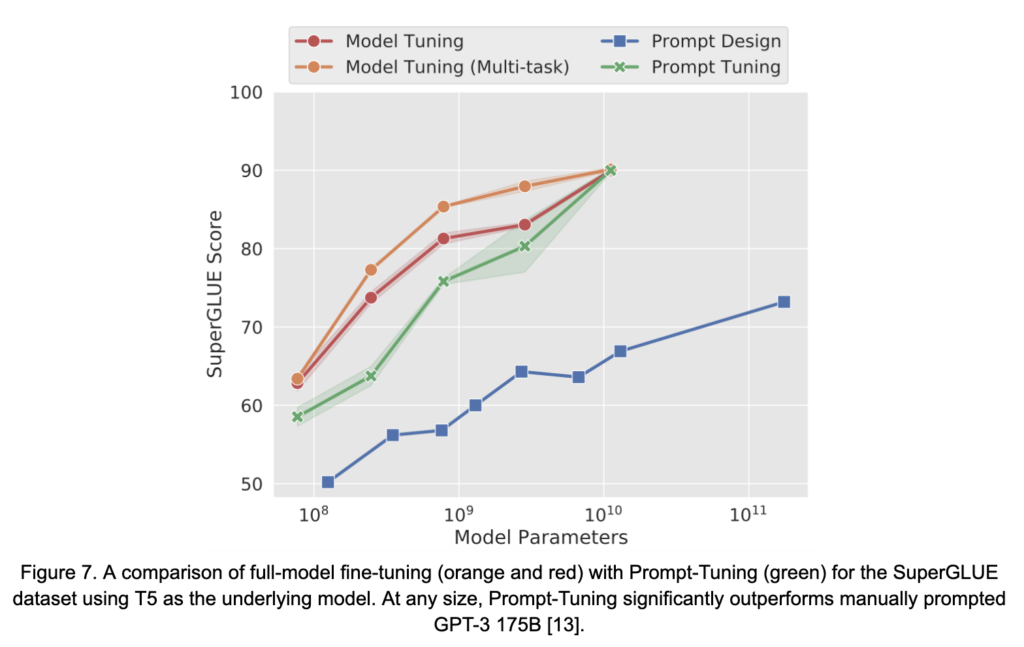

Une extension naturelle de l'optimisation discrète des invites est la relaxation de l'espace de recherche des jetons discrets vers l'espace continu des enchâssements de jetons par la manipulation ou l'augmentation de la couche d'enchâssement des LM. Ces méthodes sont connues sous le nom de techniques d'optimisation prompte continue et comprennent des méthodes telles que Prompt-Tuning [13] et Prefix-Tuning [14], et P-Tuning [16], entre autres. Ces méthodes constituent une sous-catégorie de l'optimisation paramétrique efficace (PEFT). Les méthodes PEFT entraînent une petite fraction des paramètres globaux du modèle tout en visant à récupérer la précision obtenue par un réglage fin du modèle complet. Les approches d'optimisation continue des messages-guides se concentrent sur la modification ou l'augmentation des paramètres du modèle d'une manière qui coïncide avec les messages-guides en langage naturel injectés ou qui les imite. Cette technique a permis aux approches de rivaliser avec les performances du réglage fin du modèle complet dans un certain nombre de tâches de TAL, en particulier lorsque la taille du LM sous-jacent augmente (voir la figure 7 de [13]). Ces méthodes permettent d'obtenir une mise en lot multitâche en s'assurant que les poids appropriés, spécifiques à la tâche et "associés à l'invite" accompagnent chaque exemple dans le lot pendant l'inférence. Toutefois, l'interprétabilité des "invites" apprises reste un problème et une question ouverte [11].

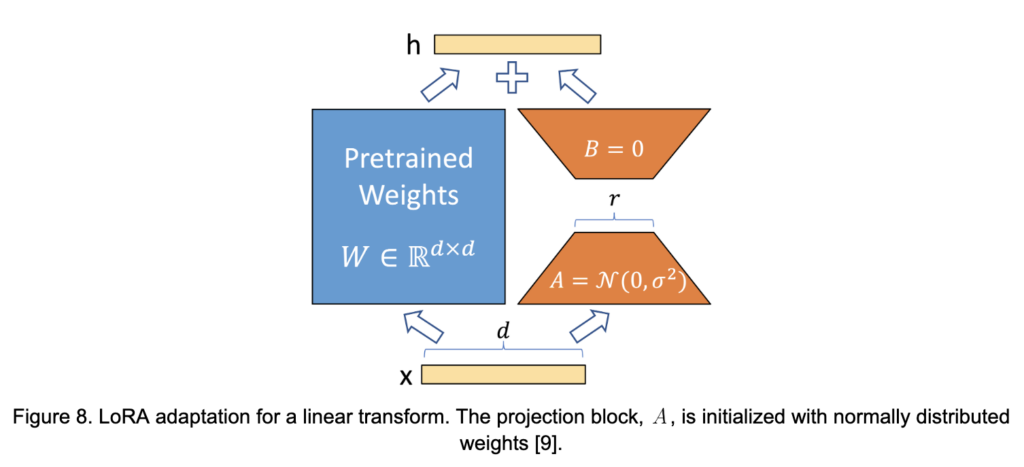

Bien que les approches d'optimisation continue de l'invite présentent de nombreux avantages, l'approche de pointe actuelle du PEFT est l'adaptation de faible rang (LoRA) [9]. LoRA généralise l'adaptation LM au-delà de l'incitation, mais se concentre toujours sur la modification du mécanisme d'attention du transformateur, comme c'est le cas dans P-Tuning, par exemple. L'idée est basée sur des observations empiriques selon lesquelles les poids LLM ont un faible "rang intrinsèque". En d'autres termes, bien que les tenseurs des LM soient de haute dimension, l'information qu'ils encodent tend en fait à être bien approximée dans une dimension beaucoup plus basse. Cela se manifeste, par exemple, par une chute précipitée des valeurs singulières associées à une décomposition de la valeur singulière des poids du modèle.

Considérons une matrice de poids . L'hypothèse sous-jacente de la LoRA est que, si

est de faible "rang intrinsèque", les mises à jour de réglage fin peuvent également l'être. Pendant la formation, LoRA fige les poids d'origine,

et contraint les mises à jour à des matrices de faible rang

de la forme

où et

et

est un petit nombre entier. Si les mises à jour de l'apprentissage sont approximativement de faible rang, les poids en

et

doit se rapprocher de la véritable mise à jour. Ceci est illustré dans la figure 8.

Il y a quatre matrices conséquentes dans l'attention multicéphale ,

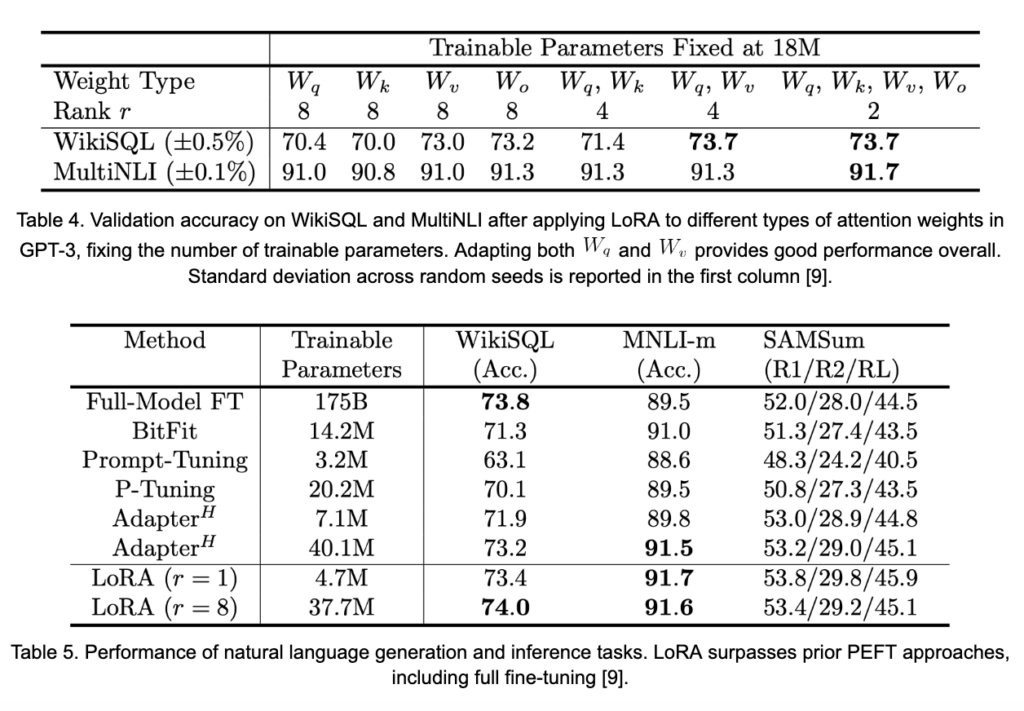

,

,

. Une question importante se pose : "quelles matrices faut-il adapter pendant la formation ?" Les résultats présentés dans le tableau 4 suggèrent que l'adaptation d'au moins les deux

et

permet d'améliorer sensiblement les performances. Il est également important de noter que l'ampleur de l'effet de la

peut être très petite, tout en offrant de bonnes performances. Les plus petits

est, moins il y a de poids formés. En adaptant les matrices d'attention de

et

dans chaque couche de la GPT-3 avec des valeurs de

de

et

LoRA est capable de capturer et de surpasser le réglage fin du modèle complet, comme le montre le tableau 5.

La mise en lots multitâches avec LoRA est un peu plus compliquée que des méthodes telles que le Prompt-Tuning. Parce que LoRA reparamètre essentiellement des composants complets du modèle par l'intermédiaire des matrices et

Ainsi, les entrées associées aux différentes tâches doivent être acheminées à travers différentes matrices LoRA afin de produire les résultats appropriés spécifiques à la tâche. Une telle approche est possible, mais elle nécessite un niveau élevé d'orchestration de l'infrastructure. Toutefois, le traitement de tâches distinctes en lots homogènes consiste simplement à appliquer les pondérations LoRA correctes, ce qui reste assez souple. L'utilisation de la LoRA pour les tâches en aval s'éloigne également de l'idée d'interagir avec les LM par le biais du langage naturel, ce qui augmente le niveau d'expertise requis pour organiser l'exécution des tâches en aval. Cependant, les avantages de LoRA en termes de performances en ont fait une approche extrêmement populaire pour atteindre efficacement une haute précision pour une variété de tâches personnalisées par le biais des LLM.

Dans ce billet, nous avons couvert une grande partie de la recherche actuelle et émergente sur les LLM. Ces modèles continuent de croître en taille, de s'entraîner sur des ensembles de données de plus en plus importants et de voir des trillions de tokens pendant leur phase de pré-entraînement. Les messages-guides et leur conception continuent d'évoluer au fur et à mesure que notre compréhension des meilleures pratiques pour communiquer avec les LLM en langage naturel devient plus claire et que les capacités des LLM sont explorées. Nous avons examiné les méthodes les plus récentes pour générer automatiquement des messages-guides optimaux, à la fois dans le contexte du langage naturel et dans les espaces à plus haute dimension des LLM eux-mêmes. Enfin, nous avons examiné deux approches récentes visant à accomplir des tâches spécifiques en aval avec une plus grande fidélité. La première, IFT, vise à améliorer la capacité des LLM à effectuer des tâches par le biais d'invites directes. La seconde, LoRA, est une technique extrêmement efficace pour affiner une petite fraction des poids totaux d'un LLM afin d'effectuer une tâche en aval avec une précision similaire à l'affinement du modèle complet, réduisant ainsi les ressources nécessaires pour obtenir une performance de pointe pour une variété de tâches.

[1] S. Agrawal, C. Zhou, M. Lewis, L. Zettlemoyer et M. Ghazvininejad. In-context examples selection for machine translation. Dans Findings of the Association for Computational Linguistics : ACL 2023, pages 8857-8873, Toronto, Canada, juillet 2023. Association for Computational Linguistics.

[2] T. Brown, B. Mann, N. Ryder, M. Subbiah, J.D. Kaplan, P. Dhariwal, A. Neelakantan et et al. Language models are few-shot learners. Dans Advances in Neural Information Processing Systems, volume 33, pages 1877-1901, 2020.

[3] W.-L. Chiang, Z. Li, Z. Lin, Y. Sheng, Z. Wu, H. Zhang, L. Zheng, S. Zhuang, Y. Zhuang, J. E. Gonzalez, et al. Vicuna : An open-source chatbot impressing GPT-4 with 90%* ChatGPT quality, Mars 2023.

[4] L. Cui, Y. Wu, J. Liu, S. Yang et Y. Zhang. Template-based named entity recognition using BART. Dans Findings of the Association for Computational Linguistics : ACL-IJCNLP 2021, pages 1835-1845, en ligne, août 2021. Association for Computational Linguistics.

[5] M. Deng, J. Wang, C.-P. Hsieh, Y. Wang, H. Guo, T. Shu, M. Song, E.P. Xing et Z. Hu. RLPrompt : Optimizing discrete text prompts with reinforcement learning (Optimisation des messages textes discrets avec apprentissage par renforcement). In Conference on Empirical Methods in Natural Language Processing, 2022.

[6] H. Duan, A. Dziedzic, N. Papernot et F. Boenisch. Flocks of stochastic parrots : Differentially private prompt learning for large language models. https://arxiv.org/abs/2305.15594, mai 2023.

[7] H. Gonen, S. Iyer, T. Blevins, N. Smith et L. Zettlemoyer. Demystifying prompts in language models via perplexity estimation. https://arxiv.org/abs/2212.04037, 12 2022.

[8] J. Hoffmann, S. Borgeaud, A. Mensch, E. Buchatskaya, T. Cai, E. Rutherford, D. de Las Casas, L.A. Hendricks, J. Welbl, A. Clark, T. Hennigan, E. Noland, K. Millican, G. van den Driessche, B. Damoc, A. Guy, S. Osindero, K. Simonyan, E. Elsen, J.W. Rae, O. Vinyals et L. Sifre. Training compute-optimal large language models. In S. Koyejo, S. Mohamed, A. Agarwal, D. Belgrave, K. Cho, and A. Oh, editors, Advances in Neural Information Processing Systems, volume 35, pages 30016-30030. Curran Associates, Inc, 2022.

[9] E. Hu, Y. Shen, P. Wallis, Z. Allen-Zhu, Y. Li, L. Wang et W. Chen. Lora : Low-rank adaptation of large language models, 2021.

[10] Z. Jiang, F.F. Xuand J. Araki, et G. Neubig. Comment pouvons-nous savoir ce que les modèles de langage savent ? Transactions of the Association for Computational Linguistics, 8:423-438, 2020.

[11] D. Khashabi, X. Lyu, S. Min, L. Qin, K. Richardson, S. Welleck, H. Hajishirzi, T. Khot, A. Sabharwal, S. Singh et Y. Choi. Prompt waywardness : The curious case of discretized interpretation of continuous prompts. In Proceedings of the 2022 Conference of the North American Chapter of the Association for Computational Linguistics : Human Language Technologies, pages 3631-3643, Seattle, États-Unis, juillet 2022. Association for Computational Linguistics.

[12] T. Kojima, S.S. Gu, M. Reid, Y. Matsuo, et Y. Iwasawa. Large language models are zero-shot reasoners. arXiv preprint arXiv:2205.11916, 2022.

[13] B. Lester, R. Al-Rfou et N. Constant. The power of scale for parameter-efficient prompt tuning. In Proceedings of the 2021 Conference on Empirical Methods in Natural Language Processing, pages 3045-3059, Online et Punta Cana, République dominicaine, novembre 2021. Association for Computational Linguistics.

[14] Xiang Lisa Li et Percy Liang. Prefix-tuning : Optimizing continuous prompts for generation. Actes de la 59e réunion annuelle de l'Association for Computational Linguistics et de la 11e conférence internationale conjointe sur le traitement du langage naturel (Volume 1 : Long Papers), abs/2101.00190, 2021.

[15] J. Liu, D. Shen, Y. Zhang, B. Dolan, L. Carin et W. Chen. Qu'est-ce qui fait de bons exemples en contexte pour GPT-3 ? Dans les actes de Deep Learning Inside Out (DeeLIO 2022) : The 3rd Workshop on Knowledge Extraction and Integration for Deep Learning Architectures, pages 100-114, Dublin, Irlande et en ligne, mai 2022. Association for Computational Linguistics.

[16] Xiao Liu, Kaixuan Ji, Yicheng Fu, Weng Tam, Zhengxiao Du, Zhilin Yang et Jie Tang. P-tuning : Le réglage rapide peut être comparable au réglage fin à travers les échelles et les tâches. In Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 2 : Short Papers), pages 61-68, Dublin, Irlande, mai 2022. Association for Computational Linguistics.

[17] Y. Lu, M. Bartolo, A. Moore, S. Riedel et P. Stenetorp. Fantastically ordered prompts and where to find them : Overcoming few-shot prompt order sensitivity. In Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1 : Long Papers), pages 8086-8098, Dublin, Irlande, mai 2022. Association for Computational Linguistics.

[18] S. Min, X. Lyu, A. Holtzman, M. Artetxe, M. Lewis, H. Hajishirzi et L. Zettlemoyer. Repenser le rôle des démonstrations : What makes in-context learning work ? In Proceedings of the 2022 Conference on Empirical Methods in Natural Language Processing, pages 11048-11064, Abu Dhabi, Émirats arabes unis, décembre 2022. Association for Computational Linguistics (Association pour la linguistique informatique).

[19] S. Mishra, D. Khashabi, C. Baral, C. Yejin et H. Hajishirzi. Reframing instructional prompts to GPTk's language. pages 589-612, 01 2022.

[20] A. Prasad, P. Hase, X. Zhou, et M. Bansal. GrIPS : Gradient-free, edit-based instruction search for prompting large language models. ArXiv, abs/2203.07281, 2022.

[21] T. Shin, Y. Razeghi, R.L. Logan IV, E. Wallace et S. Singh. Autoprompt : Eliciting knowledge from language models with automatically generated prompts. pages 4222-4235, 01 2020.

[22] H. Touvron, T. Lavril, G. Izacard, X. Martinet, M.-A. Lachaux, T. Lacroix, B. Rozi`ere, N. Goyal, E. Hambro, F. Azhar, A. Rodriguez, A. Joulin, E. Grave, et G. Lample. LLaMA : Open and efficient foundation language models, 02 2023.

[23] A. Wang, Y. Pruksachatkun, N. Nangia, A. Singh, J. Michael, F. Hill, O. Levy et S.R. Bowman. SuperGLUE : A Stickier Benchmark for General-Purpose Language Understanding Systems. Curran Associates Inc, Red Hook, NY, USA, 2019.

[24] Y. Wang, S. Mishra, P. Alipoormolabashi, Y. Kordi, A. Mirzaei, A. Naik, A. Ashok, A.S. Dhanasekaran, A. Arunkumar, D. Stap, E. Pathak, G. Karamanolakis, H. Lai, I. Purohit, I. Mondal, J. Anderson, K. Kuznia, K. Doshi, K.K. Pal, M. Patel, M. Moradshahi, M. Parmar, M. Purohit, N. Varshney, P.R. Kaza, P. Verma, R.S. Puri, R. Karia, S. Doshi, S.K. Sampat, S. Mishra, A.S. Reddy, S. Patro, T. Dixit et X. Shen. Instructions super-naturelles : Generalization via declarative instructions on 1600+ NLP tasks. In Proceedings of the 2022 Conference on Empirical Methods in Natural Language Processing, pages 5085-5109, Abu Dhabi, Émirats arabes unis, décembre 2022. Association for Computational Linguistics (Association pour la linguistique informatique).

[25] J. Wei, X. Wang, D. Schuurmans, M. Bosma, E. Chi, Q. Le et D. Zhou. Chain of thought prompting elicits reasoning in large language models. arXiv preprint arXiv:2201.11903, 2022.

[26] J. Wei, J. Wei, Y. Tay, D. Tran, D. Webson, Y. Lu, X. Chen, H. Liu, D. Huang, D. Zhou et T. Ma. Larger language models do in-context learning differently, 2023.

[27] J. Yoo, K. Perlin, S.R. Kamalakara et J.G.M Arau ́jo. Scalable training of language models using jax pjit and tpuv4. https://arxiv.org/pdf/2204.06514.pdf, 2022.

[28] W. Yuan, G. Neubig et P. Liu. BARTScore : Evaluating generated text as text generation. In M. Ranzato, A. Beygelzimer, Y. Dauphin, P.S. Liang, and J. Wortman Vaughan, editors, Advances in Neural Information Processing Systems, volume 34, pages 27263-27277. Curran Associates, Inc, 2021.

[29] S. Zhang, S. Roller, N. Goyal, M. Artetxe, M. Chen, S. Chen, C. Dewan, M. Diab, X. Li, X. V. Lin, T. Mihaylov, M. Ott, S. Shleifer, K. Shuster, D. Simig, P. S. Koura, A. Sridhar, T. Wang et L. Zettlemoyer. OPT : Open pre-trained transformer language models. arXiv:2205.01068, 2022.