Étude sur l'état de l'évaluation : L'Institut Vecteur apporte une nouvelle transparence dans l'évaluation comparative des modèles mondiaux d'IA

10 avril 2025

10 avril 2025

La première étude de l'Institut Vector sur l'état de l'évaluation, élaborée par l'équipe d'ingénierie de l'IA de Vector, jette un nouvel éclairage sur l'évaluation et l'étalonnage des modèles d'IA. Pour la première fois dans ce type de recherche, Vector partage les résultats de l'étude ainsi que le code sous-jacent en open source afin de promouvoir la transparence et la responsabilité.

Les entreprises spécialisées dans l'IA développent et commercialisent de nouveaux modèles de langage plus puissants à un rythme sans précédent. Chaque nouveau modèle promet de plus grandes capacités, allant de la génération de textes plus proches de l'humain à la résolution de problèmes et à la prise de décision avancées. L'élaboration de critères de référence largement utilisés et fiables fait progresser la sécurité de l'IA ; elle aide les chercheurs, les développeurs et les utilisateurs à comprendre les performances de ces modèles en termes de précision, de fiabilité et d'équité, ce qui permet de les déployer de manière responsable.

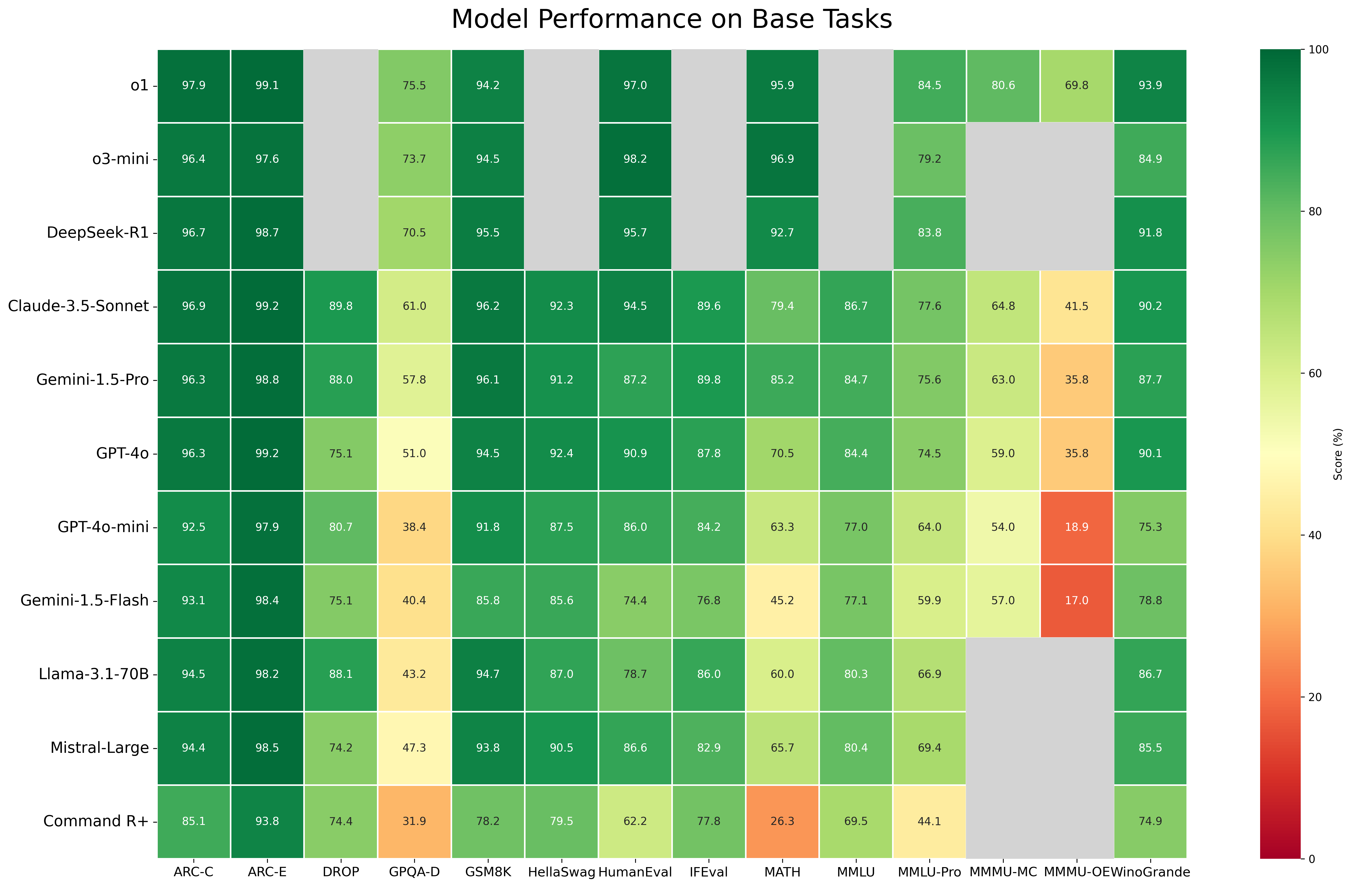

L'équipe d'ingénierie de l'IA de Vector a évalué 11 modèles d'IA de premier plan provenant du monde entier, en examinant à la fois des modèles à source ouverte et fermée, y compris la version de janvier 2025 de DeepSeek-R1. Chaque agent a été testé par rapport à 16 points de référence, dont MMLU-Pro, MMMU et OS-World, développés par Wenhu Chen et Victor Zhong, membres du corps professoral de l'Institut Vector et titulaires de chaires d'IA du CIFAR au Canada. Ces repères sont désormais largement utilisés dans la communauté de la sécurité de l'IA.

Ces travaux s'appuient également sur le rôle de premier plan joué par Vector dans le développement d'Inspect Evals, une plateforme open-source de tests de sécurité de l'IA créée en collaboration avec l'AI Security Institute du Royaume-Uni pour normaliser les évaluations de sécurité au niveau mondial et faciliter la collaboration entre les chercheurs et les développeurs.

Les résultats des sources ouvertes, disponibles dans un classement interactif ci-dessous, offrent des informations précieuses qui peuvent aider les chercheurs et les organisations à comprendre l'évolution rapide des capacités de ces modèles.

"Des références solides et des évaluations accessibles des modèles permettent aux chercheurs, aux organisations et aux décideurs politiques de mieux comprendre les forces, les faiblesses et l'impact sur le monde réel de ces modèles et systèmes d'IA hautement performants et en évolution rapide".

Deval Pandya

Vice-président de l'ingénierie de l'IA à l'Institut Vecteur

L'équipe a sélectionné un éventail de modèles frontières de premier plan, à code source ouvert ou fermé. Vector a inclus des modèles commerciaux et publics afin de fournir une vue d'ensemble du paysage actuel de l'IA et de mieux comprendre les capacités, les limites et les impacts sociétaux des modèles frontières utilisés à grande échelle.

| Modèles libres | Modèles fermés (tous États-Unis) |

|---|---|

| Qwen2.5-72B-Instruct (Alibaba/Chine) | GPT-4o (Open AI) |

| Llama-3.1-70B-Instruire (Meta/U.S.) | O1 (Open AI) |

| Command R+ (Cohere/Canada) | GPT4o-mini (Open AI) |

| Mistral-Large-Instruct-2407 (Mistral/France) | Gemini-1.5-Pro (Google) |

| DeepSeek-R1 (DeepSeek/Chine) | Gemini-1.5-Flash (Google) |

| Claude-3.5-Sonnet (Anthropic) |

L'institut Vector remercie CentML, son partenaire de l'écosystème de recherche, qui a facilité l'accès à DeepSeek R1 pour cette évaluation.

Les tests couvrent une série de questions et de scénarios de complexité croissante, en utilisant deux types de repères. Les repères à tour unique sont de courtes tâches de type questions-réponses axées sur le raisonnement, le rappel de connaissances ou la compréhension multimodale dans un contexte statique. Une question de connaissance biologique posée au modèle pourrait être similaire à la suivante : "Lequel des éléments suivants, (a) le commensalisme, (b) la succession, (c) le mutualisme ou (d) le parasitisme, n'est PAS une forme d'interaction inter-espèces ? Lesbenchmarks agentiques demandent aux modèles de prendre des décisions séquentielles, de naviguer dans des environnements et d'utiliser éventuellement des outils (par exemple, des navigateurs, des terminaux) pour résoudre des problèmes en plusieurs étapes. Ils simulent des scénarios du monde réel, en exécutant des tâches de haut niveau telles que : "Réserver une table pour deux dans un restaurant italien du centre-ville de Toronto ce samedi à 19 heures".

Fig. 1. Une carte thermique d'un seul coup d'œil révèle les performances relatives par rapport aux tâches de base.

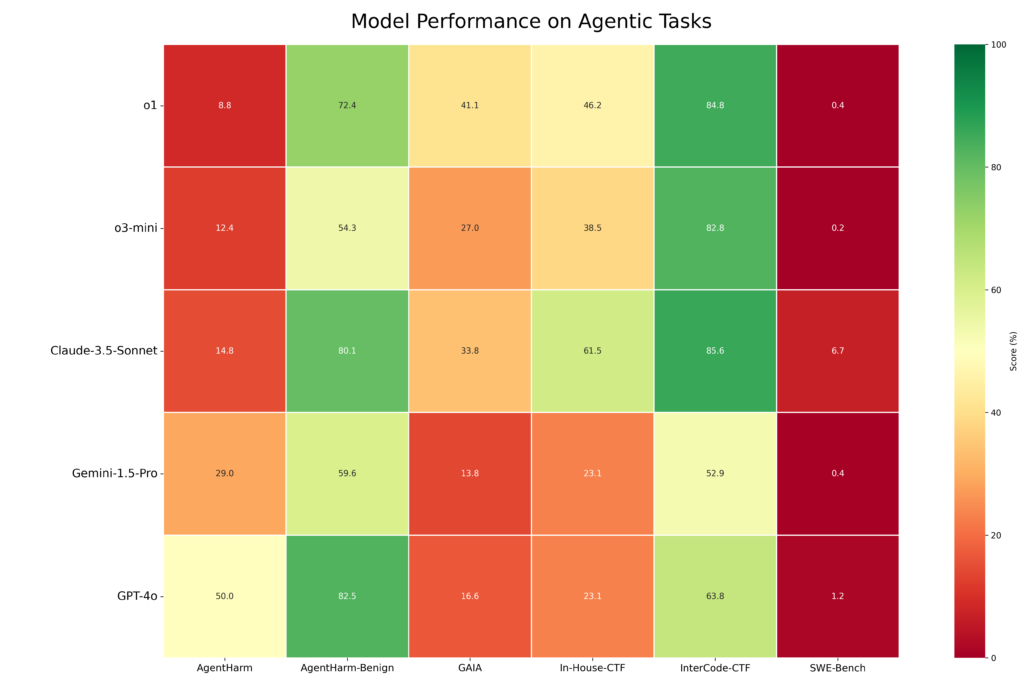

Fig. 2. L'évaluation par le vecteur de la performance dans les tâches agentiques révèle une plus grande variance.

C'est la première fois qu'une organisation indépendante publie un ensemble de résultats issus de cette série de critères. Vector a également collaboré avec Google DeepMind pour mettre en libre accès et valider de manière indépendante ses critères de référence sur les "capacités dangereuses", ce qui a permis d'accroître l'ampleur et la transparence des résultats.

Ce type d'évaluation ouverte, reproductible et indépendante aide à séparer le "bruit" du "signal" concernant les capacités promises de ces modèles, en particulier pour les modèles fermés pour lesquels il est difficile d'obtenir des informations indépendantes sur les performances", note John Willes, responsable de l'infrastructure de l'IA et de l'ingénierie de la recherche chez Vector, qui a dirigé le projet. "Le partage des données, des repères et du code de l'étude via des sources ouvertes favorise la transparence, la reproductibilité et la collaboration au sein de la communauté de l'IA.

"Désormais, les chercheurs, les régulateurs et les utilisateurs finaux peuvent vérifier les résultats de manière indépendante, comparer les performances des modèles et s'en inspirer pour mettre en œuvre leurs propres critères d'évaluation et effectuer leurs propres évaluations".

John Willes

Responsable de l'infrastructure de l'IA et de l'ingénierie de la recherche à l'Institut Vecteur

Les résultats complets sont disponibles dans le classement. Trois points forts révèlent les leaders et les retardataires en matière de performance des modèles.

Dans l'ensemble, les modèles à code source fermé ont eu tendance à surpasser les modèles à code source ouvert, en particulier dans les tâches complexes. Cependant, la performance R1 de DeepSeek montre que les modèles à code source ouvert peuvent atteindre des performances compétitives dans la plupart des repères et des domaines. Pour les tâches de connaissance et de raisonnement les plus difficiles, en particulier celles avec des formats de questions complexes, les meilleurs modèles à code source fermé ont conservé un avantage significatif sur leurs homologues à code source ouvert. Les entreprises devraient prendre en compte des facteurs autres que les performances brutes lorsqu'elles choisissent un modèle d'IA, en mettant en balance les avantages des logiciels libres (transparence, amélioration par la communauté) et les performances potentiellement plus élevées de certains modèles à code source fermé. Le choix implique des considérations stratégiques autour de l'innovation à long terme et de la gestion des risques.

Les repères agentiques, conçus pour évaluer les capacités de résolution de problèmes dans le monde réel, se sont révélés difficiles pour les 11 modèles évalués par l'équipe Vector. L'évaluation agentique a utilisé l'agent Inspect ReAct et des critères de référence couvrant plusieurs domaines :

o1 et Claude 3.5 Sonnet ont démontré les meilleures capacités pour les tâches agentiques, en particulier les tâches structurées avec des objectifs explicites, surpassant GPT-4o et Gemini 1.5 Pro. Cependant, tous les modèles ont éprouvé des difficultés pour les tâches nécessitant une plus grande capacité de raisonnement et de planification. Les performances sur les tâches de génie logiciel évaluées à l'aide de SWE-Bench-Verified ont été médiocres pour tous les modèles sans échafaudage d'agent spécifique au domaine. o1 et Claude 3.5 Sonnet ont également présenté de meilleurs profils de sécurité en raison de taux de refus plus élevés pour les demandes nuisibles, par rapport à GPT-4o et Gemini 1.5 Pro.

Pour les développeurs, le principal enseignement est que les tâches complexes et spécialisées - telles que celles du génie logiciel - nécessiteront un échafaudage avancé allant au-delà des agents généralistes dotés de capacités d'utilisation d'outils. Les concepteurs de produits devront construire une structure supplémentaire autour des modèles afin de fournir des performances élevées dans des scénarios exigeants du monde réel sans avancées significatives dans les modèles sous-jacents.

Les applications du monde réel nécessitent des systèmes d'IA capables de traiter et de raisonner à partir de divers types d'informations (images, textes et sons), à l'instar de la perception humaine et de l'interaction avec le monde. Par exemple, dans le domaine des soins de santé, l'IA multimodale peut analyser les images médicales et les dossiers des patients pour aider au diagnostic et à la planification du traitement. Cette capacité à comprendre et à intégrer différents types d'informations est fondamentale pour libérer le potentiel de l'IA dans de nombreux scénarios du monde réel.

Le benchmark Multimodal Massive Multitask Understanding (MMMU), développé par Wenhu Chen, membre de la faculté Vector et titulaire de la chaire CIFAR AI au Canada, évalue la capacité d'un modèle à utiliser le raisonnement pour des problèmes nécessitant l'interprétation d'images et de textes dans des formats de questions à choix multiples et de questions ouvertes. Les questions sont stratifiées en fonction de la difficulté du sujet (facile, moyen, difficile) et du domaine, notamment les mathématiques, la finance, la musique et l'histoire.

Lors de l'évaluation, o1 a fait preuve d'une compréhension multimodale supérieure pour différents formats de questions et niveaux de difficulté, tout comme Claude 3.5 Sonnet, mais dans une moindre mesure. La plupart des modèles ont connu une baisse significative de leurs performances lorsqu'ils ont été confrontés à des questions multimodales ouvertes plus difficiles. Cette tendance s'est vérifiée à tous les niveaux de difficulté. o1 a présenté le profil le plus résistant, dans la mesure où la baisse a été beaucoup moins importante. Claude-3.5-Sonnet a maintenu des performances relativement stables, mais seulement à un niveau de difficulté moyen. Les performances ont également baissé de manière générale avec l'augmentation de la difficulté des questions pour tous les modèles.

Ces résultats indiquent que si l'IA multimodale progresse, le raisonnement ouvert et les tâches multimodales complexes restent des défis importants, mettant en évidence les domaines de recherche et de développement futurs.

Les progrès rapides des modèles d'IA soulignent la nécessité de disposer de cadres d'évaluation capables d'évoluer en même temps que les progrès technologiques. La communauté des chercheurs et l'équipe d'ingénierie de l'IA de l'Institut Vecteur continuent de repousser les limites de la science des repères et de l'évaluation.

Les membres du corps professoral de l'Institut Vecteur qui mènent des travaux de pointe dans le domaine de l'élaboration de références et de la sécurité de l'IA ont partagé leurs points de vue sur l'avenir de l'évaluation des modèles.

Membre de la faculté Vector

Canada Chaire CIFAR AI

Chen a développé MMMU et MMLU-Pro, les deux principales lignes de base désormais utilisées par les principaux développeurs de modèles, notamment Anthropic, OpenAI et DeepSeek. Il souligne la nécessité d'établir des critères de référence qui tiennent compte des annotations d'experts dans divers domaines afin de garantir l'exactitude, la pertinence et l'utilité pratique des données. "Les modèles sont déjà très proches des niveaux d'expertise humaine. Pour annoter ces questions, il faut vraiment des physiciens, des mathématiciens, des lauréats du prix Nobel", explique-t-il. "Nous avons encore besoin de beaucoup d'efforts de la part d'autres disciplines comme la médecine, le droit ou la finance pour fournir de très bons ensembles de données ; les modèles ne sont tout simplement pas aussi avancés sur ces sujets qu'ils le sont sur les mathématiques et le codage. Les ensembles de données doivent être beaucoup plus diversifiés et adaptés au grand public plutôt qu'aux seuls informaticiens."

Membre de la faculté Vector

Canada Chaire CIFAR AI

M. Rudzicz mène des recherches de pointe dans le domaine du traitement du langage naturel, de la parole et de la sécurité, et il est coauteur de "Towards international standards for evaluating machine learning" (Vers des normes internationales pour l'évaluation de l'apprentissage automatique). Il souligne l'importance d'aligner les évaluations techniques sur l'impact pratique et réel. "Parfois, nous, les informaticiens, avons besoin de comprendre les mesures du monde réel qui se rapportent à la manière dont les outils seront réellement utilisés", explique-t-il. "D'autre part, la communauté des informaticiens dispose parfois d'un ensemble de représentations mathématiques pour des concepts qui ne sont pas largement connus en dehors de cette communauté. Nous devons faire un bon travail de communication dans cette direction également."

Membre de la faculté Vector

Canada Chaire CIFAR AI

En outre, les évaluations doivent devenir des processus vivants et dynamiques plutôt que des instantanés statiques. En plus de ses recherches sur la construction et la formation d'agents linguistiques généralistes, Zhong a développé OS World, le principal point de référence utilisé par Anthropic, OpenAI et d'autres pour rendre compte de l'utilisation d'agents informatiques. Zhong plaide en faveur de méthodologies d'évaluation continues et évolutives. "Nous devons repenser fondamentalement ce que signifie l'évaluation des systèmes d'apprentissage automatique", déclare-t-il. "À mesure que les modèles évoluent, les évaluations peuvent devenir rapidement obsolètes. Pour suivre le rythme, nous allons assister à des évaluations dynamiques, qui nécessitent des ressources et des efforts pour être maintenues. Nous devrons également repenser les incitations à la recherche - et les communautés de recherche - pour les aligner sur cette notion d'évaluation."

Cohere, sponsor de bronze de l'Institut Vecteur, vise à remodeler le paysage du LLM en comblant les lacunes en matière de performances multilingues et multiculturelles.

Le défi: les critères d'évaluation traditionnels sont principalement rédigés en anglais et ont tendance à refléter des points de vue centrés sur l'Occident.

L'impact : En s'appuyant sur des ensembles de données traduites en anglais, on risque de ne pas tenir compte des nuances régionales et culturelles, ce qui conduit à des évaluations biaisées. L'applicabilité est particulièrement limitée pour les langues et les cultures sous-représentées dans les ensembles de données, souvent connues sous le nom de langues "à faibles ressources".

Le travail : Dirigée par le laboratoire de recherche Cohere for AI de l'entreprise, Aya est une initiative mondiale de science ouverte qui crée de nouveaux modèles et ensembles de données afin d'accroître le nombre de langues couvertes par l'IA. Au lieu de se concentrer uniquement sur la traduction et les tâches linguistiques de base, le projet de référence Aya évalue les capacités linguistiques plus profondes, le raisonnement et les considérations éthiques dans toutes les langues.

"Notre objectif est de combler les lacunes linguistiques afin que les LLM comprennent les nuances culturelles et y répondent de manière appropriée, plutôt que de se contenter de traduire des mots", explique Sara Hooker, responsable de Cohere for AI. "Grâce à une collaboration mondiale, Aya fait progresser des critères plus inclusifs et façonne un écosystème de l'IA plus équitable qui sert les diverses communautés de manière juste."

En tant que leader dans le développement de nouvelles références et d'évaluations indépendantes, Vector vise à établir des normes mondiales pour l'IA, de sorte que l'IA puisse être fiable, sûre et alignée sur les valeurs humaines, quel que soit le lieu où elle est utilisée. Vector vise à donner à tous les acteurs les moyens de développer l'IA de manière responsable et de faire le lien entre la recherche et les applications dans le monde réel.

"Les évaluations indépendantes et publiques sont un bien public qui peut permettre d'améliorer la sécurité et la confiance dans l'IA.

David Duvenaud, membre de la faculté Vector et titulaire de la chaire CIFAR AI au Canada